1. Étant donné que tous les manuscrits ne sont pas copiés un nombre pair de fois, les démonstrations mathématiques comme celles ci-dessus ne sont pas valides.

Mais c’est mal comprendre le but de telles manifestations. Bien sûr, le schéma donné ci-dessus est une situation « idéalisée » qui ne représente pas ce qui s’est réellement passé. Au lieu de cela, cela montre simplement que toutes choses étant égales par ailleurs, la probabilité statistique favorise la perpétuation à chaque génération du statut de majorité originelle de la lecture authentique. Et il faut alors garder à l’esprit que plus la majorité initiale est grande, plus cet argument des probabilités devient convaincant. Développons ce point.

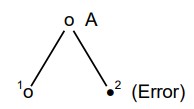

Si nous imaginons une tige comme suit :

*(Erreur)

dans lequel A = autographe et (1 ) et (2) sont des copies faites à partir de celui-ci, il est évident que, dans l’abstrait, l’erreur de (2) a une chance égale de se perpétuer en nombre égal avec la lecture authentique de (1 ). Mais, bien sûr, en réalité (2) peut être copié plus fréquemment que (1) et ainsi l’erreur se perpétue dans un plus grand nombre de manuscrits postérieurs que la vraie lecture en (1).

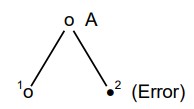

Pour l’instant ça va. Mais supposons :

*True Reading (a) = Lecture vraie (a) / Error (a) = Erreur (a) / True Reading (b) = Lecture vraie (b) / Error (b) = Erreur (b)

Maintenant, nous avons concédé que l’erreur désignée (a) se perpétue en plus grand nombre que la vraie lecture (a), de sorte que « l’erreur (a) » se trouve dans les copies 5-6-7-8, tandis que la « vraie lecture (a) » ne se trouve que dans les copies 3 et 4. Mais lorsque « l’erreur (b) » est introduite dans la copie 8, sa rivale (« lecture vraie (b) ») se trouve dans les exemplaires 3-4-5-6-7. 1 Quelqu’un supposera-t-il qu’à ce stade, il est probable que « l’erreur (b) » aura la même chance que « l’erreur (a) » et que le manuscrit 8 sera copié plus souvent que 3-4-5-6-7 réunis ?

1 Par « erreur (b) », nous entendons, bien sûr, une erreur commise à un autre endroit dans le texte transmis par l’autographe. Nous ne voulons pas dire que l'« erreur (b) » a été remplacée par « l’erreur (a) ». Par conséquent, alors que les copies 5-6-7 contiennent « l’erreur (a) », elles contiennent également la lecture autographe originale qui est la rivale de « l’erreur (b) ».

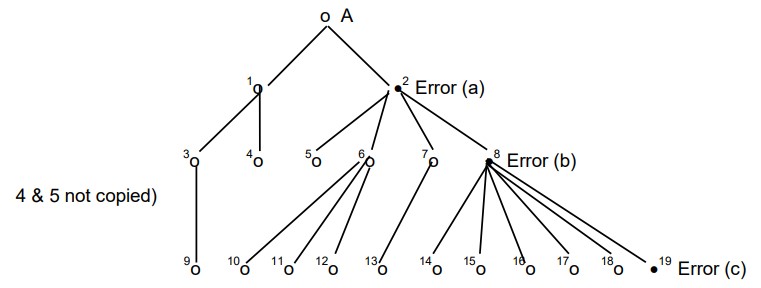

Mais même en admettant cette situation beaucoup moins probable, supposons encore :

*(4 & 5 not copied) = (4 & 5 non copiés) /Error =Erreur

Quelqu’un croira-t-il que les probabilités favorisent une répétition de la même situation pour « l’erreur (c) » dans la copie 19 ?

N’est-il pas évident qu’à mesure que les manuscrits se multiplient et que les erreurs s’introduisent plus loin dans le flux de transmission, la probabilité que l’erreur soit copiée plus fréquemment que le nombre de plus en plus grand de textes rivaux diminue considérablement ?

Ainsi, admettre que certaines erreurs pourraient être copiées plus fréquemment que la lecture concurrente et authentique ne touche en rien au cœur de notre argumentation. La raison en est simple : la critique moderne rejette de manière répétée et systématique les lectures majoritaires à très grande échelle. Mais, avec chaque rejet de ce type, la probabilité que ce rejet soit valide est considérablement réduite. Renverser plusieurs fois les probabilités statistiques est une chose. Les renverser de manière répétée et persistante en est une autre !

Par conséquent, nous continuons d’insister sur le fait que rejeter les lectures de texte majoritaires en grand nombre sans fournir une justification globale crédible pour cette procédure revient à aller aveuglément à l’encontre de toute probabilité raisonnable.

2. Le texte majoritaire peut être expliqué comme le résultat d’un « processus » qui a abouti à la formation progressive d’un type de texte numériquement prépondérant.

Le point de vue du « processus » du texte majoritaire semble gagner en faveur aujourd’hui parmi les érudits textuels du Nouveau Testament. Pourtant, à ma connaissance, personne n’a offert d’explication détaillée de ce qu’était exactement le processus, quand il a commencé, ou comment, une fois commencé, il a atteint le résultat revendiqué. En effet, les partisans du point de vue du « processus » sont probablement bien avisés de rester vagues à ce sujet parce que, à première vue, il semble impossible de concevoir un quelconque type de processus qui soit à la fois historiquement crédible et adéquat pour rendre compte de tous les faits. Il faut se rappeler que le texte de la majorité est relativement uniforme dans son caractère général, avec des variations relativement faibles entre ses principaux représentants. 2

2 Les mots clés ici sont « relativement » et « comparativement ». Naturellement, les membres individuels du texte majoritaire montrent des degrés divers de conformité à celui-ci. Néanmoins, la proximité de ses représentants par rapport à la norme générale n’est pas difficile à démontrer dans la plupart des cas. Par exemple, dans une étude portant sur une centaine de lieux de variation dans Jean 11, les représentants du texte majoritaire utilisé dans l’étude ont montré une fourchette d’accord allant d’environ 70 % à 93 %. Cf. Ernest C. Colwell et Ernest W. Tune, pp. 28,31. L’accord de 93 % du codex oncial Omega avec le Textus Receptus se compare bien à l’accord de 92 % trouvé entre P75 et B. L’affinité d’Omega avec le TR est plus typique du modèle que l’on trouverait dans la grande masse de textes minuscules. Des niveaux élevés d’accord de ce type sont (comme dans le cas de P75 et B) le résultat d’une base ancestrale commune. Ce sont les divergences qui sont le résultat d’un « processus » et non l’inverse.

Un exposé plus général et sommaire de la question est fait par Epp : « ... les manuscrits byzantins ensemble, après tout, forment un groupe assez soudé, et les variations en question au sein de l’ensemble de ce grand groupe sont relativement mineures. (Eldon Jay Epp, « La méthode du profil de Claremont pour regrouper les manuscrits minuscules du Nouveau Testament », p. 33.)

Personne n’a encore expliqué comment un processus long et lent, s’étendant sur plusieurs siècles et sur une vaste zone géographique, et impliquant une multitude de copistes, qui souvent ne connaissaient rien de l’état du texte en dehors de leurs propres monastères ou scriptoria (salles destinées à faciliter la copie fidèle des manuscrits), a pu atteindre cette uniformité généralisée à partir de la diversité présentée par les formes antérieures du texte. Même une édition officielle du Nouveau Testament – promue avec la sanction ecclésiastique dans tout le monde connu – aurait eu beaucoup de mal à atteindre ce résultat, comme le démontre amplement l’histoire de la Vulgate de Jérôme. 3 Mais un processus non guidé qui parvient à une stabilité et à une uniformité relatives dans les circonstances textuelles, historiques et culturelles diversifiées dans lesquelles le Nouveau Testament a été copié, impose à notre imagination des contraintes impossibles.

3 Après avoir décrit les vicissitudes qui ont affecté la transmission de la Vulgate, Metzger conclut : « En conséquence, les plus de 8 000 manuscrits de la Vulgate qui existent aujourd’hui présentent la plus grande quantité de contamination croisée des types textuels. » {Texte du Nouveau Testament, p. 76.) L’uniformité du texte est toujours la plus grande à la source et diminue – plutôt qu’elle n’augmente – à mesure que la tradition s’étend et se multiplie. Cette mise en garde n’est pas prise en compte par le point de vue du « processus » du texte majoritaire.

Il semble donc que plus le point de vue du « processus » peut être formulé de façon claire et précise, plus il est susceptible d’être vulnérable à toutes les objections potentielles qui viennent d’être mentionnées. De plus, lorsqu’une telle vision sera exprimée, elle devra se situer définitivement quelque part dans l’histoire, avec de nombreux inconvénients supplémentaires pour ses défenseurs. Car, qu’on se souvienne, tout comme l’histoire est muette sur toute « recension syrienne » (comme celle imaginée par Hort), de même l’histoire est silencieuse sur tout type de « processus » qui influençait ou guidait d’une manière ou d’une autre les scribes au fur et à mesure que les manuscrits étaient transmis. Les critiques modernes sont les premiers à découvrir un tel « processus », mais avant de l’accepter, nous devrons avoir plus que des affirmations vagues et non documentées à son sujet.

Il ne semble pas injuste de dire que la tentative d’expliquer le texte majoritaire par un « processus » obscur et nébuleux est un aveu implicite de faiblesse de la part de la critique contemporaine. L’érosion du point de vue de Westcott et Hort, qui faisait remonter ce texte à une recension officielle et définitive du Nouveau Testament, a créé un vide très difficile à combler. Plus que jamais, semble-t-il, les critiques ne peuvent pas rejeter le texte de la majorité et en même temps l’expliquer. Et c’est là où nous voulons en venir ! Le rejet du texte de la majorité et l’explication crédible de ce texte sont tout à fait incompatibles l’un avec l’autre. Mais l’acceptation du texte de la majorité fournit immédiatement une explication de ce texte et des textes rivaux !

Et c’est l’essence même de la démarche scientifique que de préférer les hypothèses qui expliquent les faits disponibles à celles qui ne le font pas !